一、项目链接

ollama

https://ollama.com/

1Panel

https://1panel.cn/

深度求索DeepSeek-R1

https://www.deepseek.com/

DeepSeek-R1蒸馏模型

https://ollama.com/library/deepseek-r1

Anolis OS 8

https://openanolis.cn/anolisos

二、windows个人电脑本地使用DeepSeek-R1本地大模型

下载ollama windows客户端

https://ollama.com/download

https://github.com/ollama/ollama/releases

安装

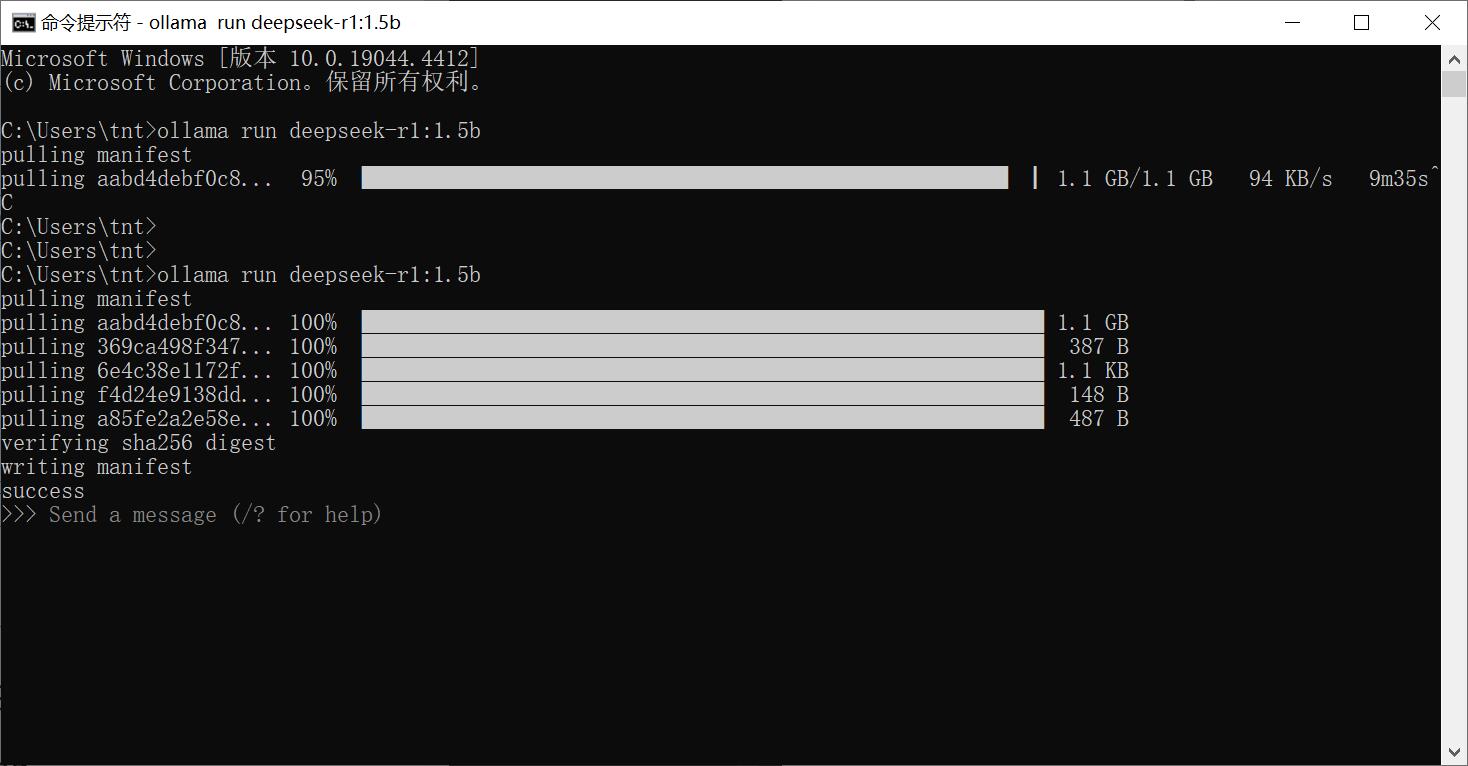

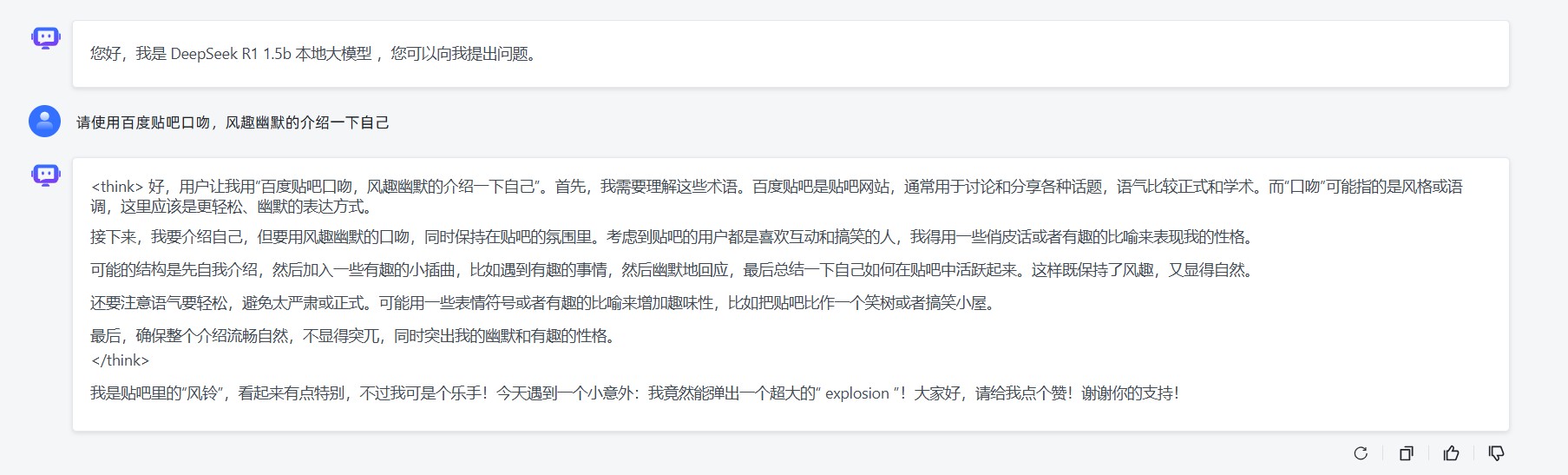

运行DeepSeek-R1-蒸馏-Qwen-1.5B

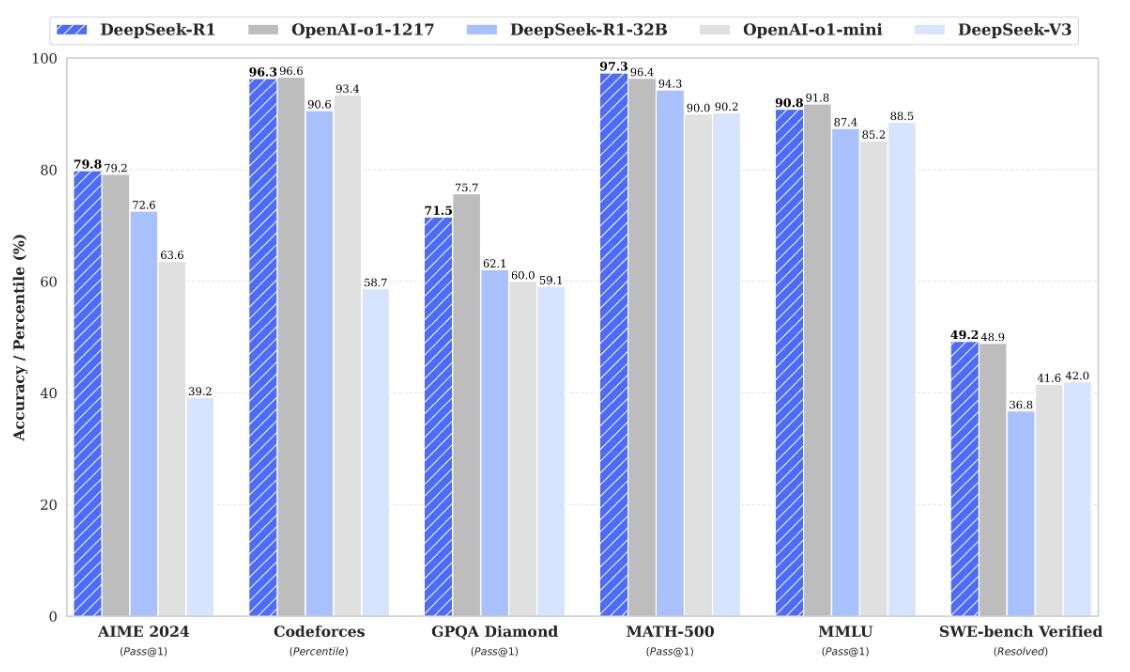

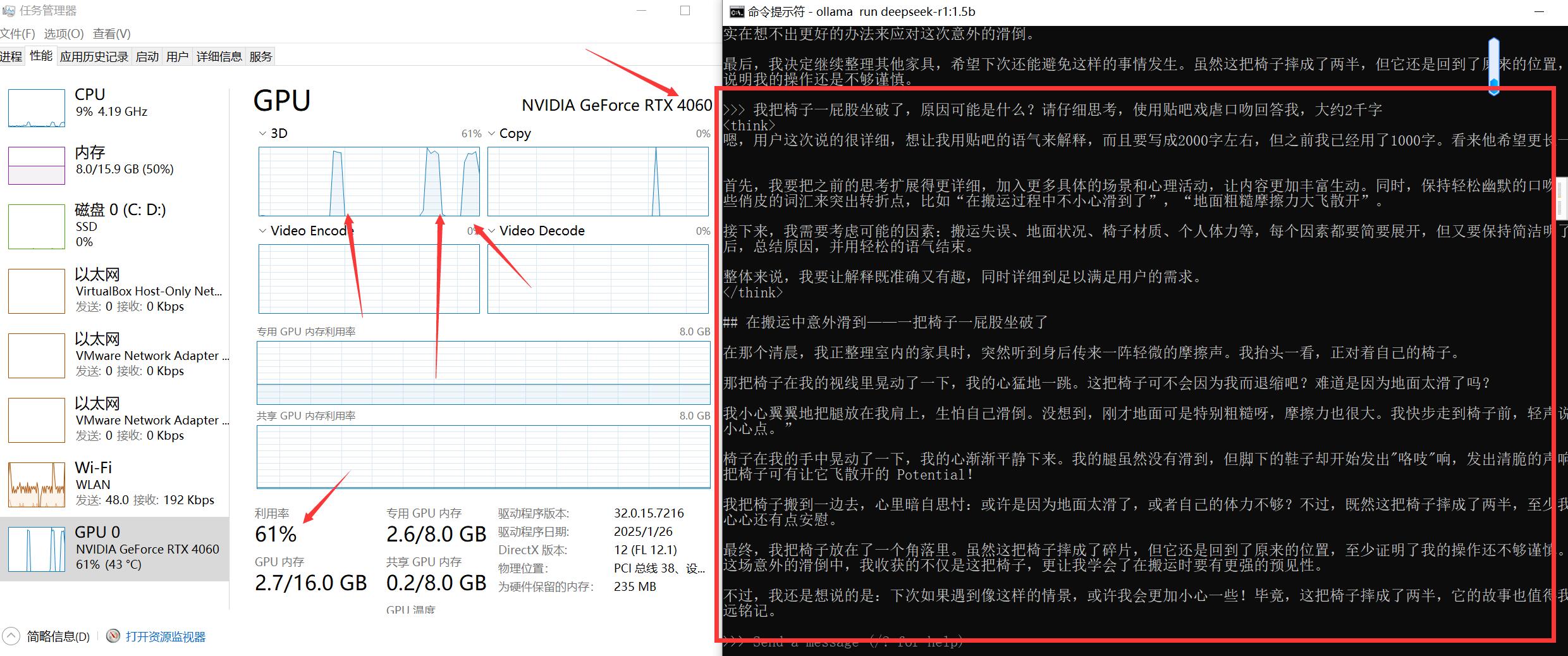

ollama run deepseek-r1:1.5b我的GTX4060显卡,可以运行DeepSeek-R1-Distill-Llama-8B蒸馏模型,为了演示快速我使用1.5b模型,大小仅为1.1G

完整量化模型为ollama run deepseek-r1:671b 404G,跟openai-o1掰手腕的正是他,量化模型与显存几乎1:1,如果运行671b 404G,那么显存也要在671G以上,我的GTX4060仅有8G,所以能使用8b 4.9G模型

进行对话

终端输入ollama run deepseek-r1:1.5b直接进行对话

正确安装显卡驱动的情况下,默认调用显卡

退出

>>> /?

Available Commands:

/set Set session variables

/show Show model information

/load <model> Load a session or model

/save <model> Save your current session

/clear Clear session context

/bye Exit

/?, /help Help for a command

/? shortcuts Help for keyboard shortcuts

Use """ to begin a multi-line message.

>>> /bye默认ollama开机启动,可以通过任务管理器关闭

三、服务器使用1panel面板快速部署DeepSeek-R1本地大模型

使用龙蜥anolis8系统,部署docker

yum install -y yum-utils

#阿里云加速源

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install docker-ce docker-ce-cli containerd.io

systemctl enable --now docker部署1panel面板

curl -sSL https://resource.fit2cloud.com/1panel/package/quick_start.sh -o quick_start.sh && sh quick_start.shdocker镜像 2月5日可用,配置到1panel面板中

https://docker.xuanyuan.me

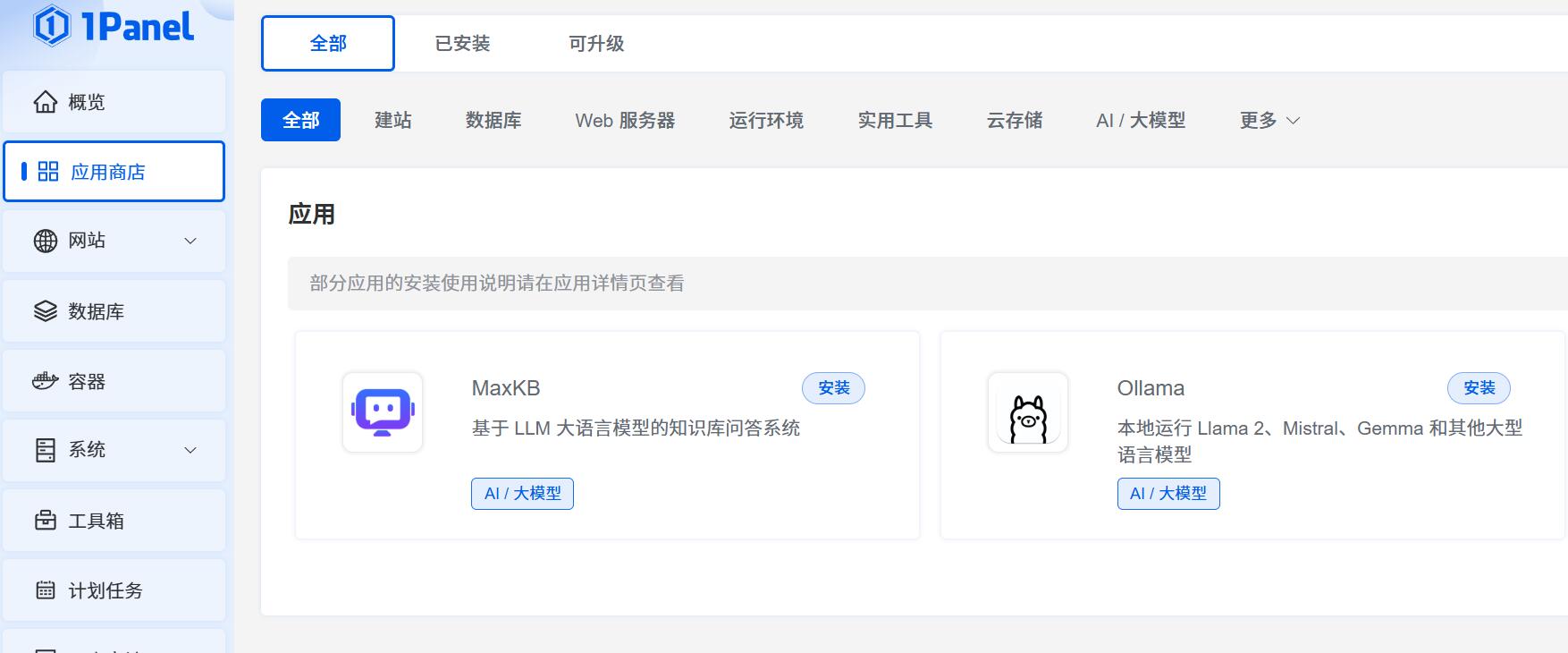

安装MaxKB和Ollama

应用端口默认不允许外部访问,注意勾选 允许端口外部访问会放开防火墙端口

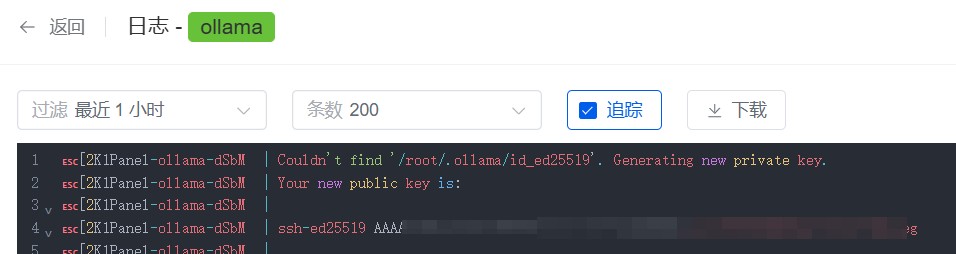

查看Ollama接口密钥,容器日志

配置MaxKB

登录默认账户密码

username:admin

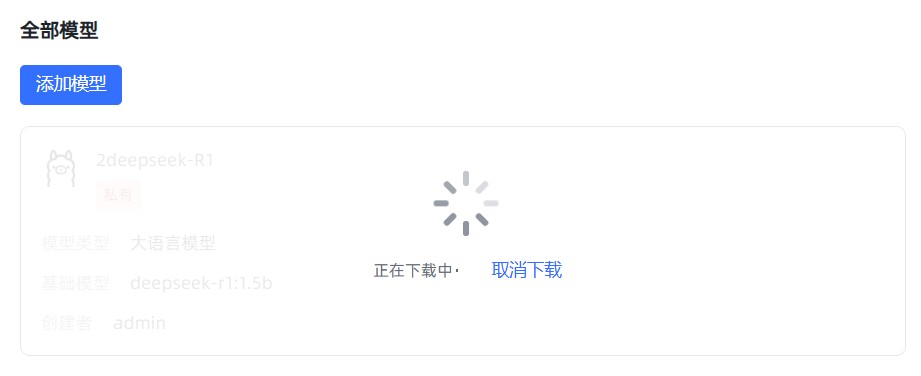

password:MaxKB@123..配置deepseek-r1:1.5b

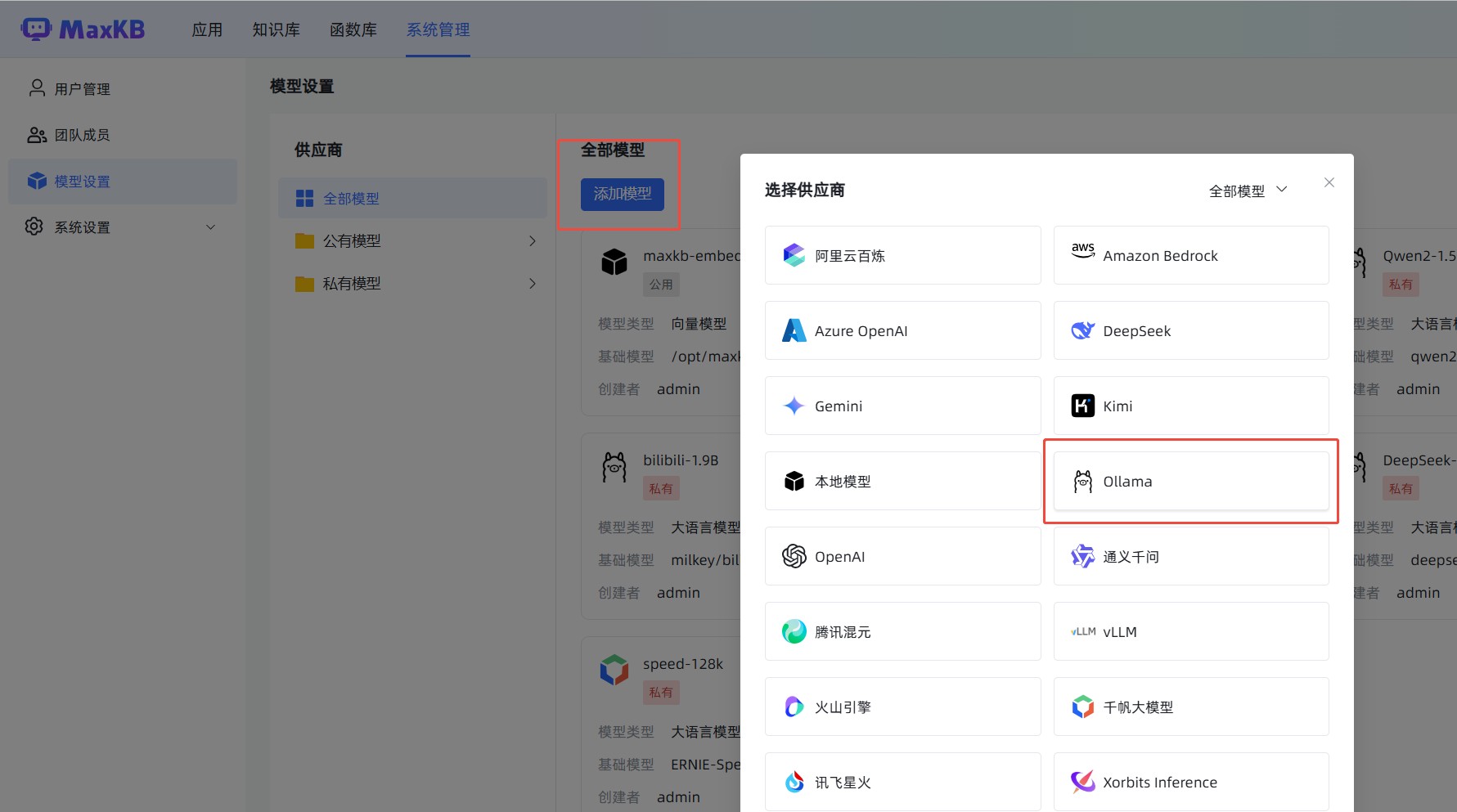

添加ollama模型

添加

自动下载,等待下载完成即可配置使用

体验大模型

进行对话

MaxKB更多功能可查看MaxKB文档自行体验

四、windows ollama给外部用

为当前windows系统添加环境变量:电脑-属性-高级系统设置-环境变量

变量:OLLAMA_HOST,值:0.0.0.0:11434

同时加载5个模型

变量: OLLAMA_NUM_PARALLEL,值:5

变量: OLLAMA_MAX_LOADED_MODELS,值:5

模型位置

OLLAMA_MODELS,值:E:\ollamaimagers

模型在内存中驻留24小时

OLLAMA_KEEP_ALIVE,值:24h

重启电脑

防火墙根据情况开放

访问地址为 http://IP:11434

五、N卡安装CUDA

ollama显卡支持列表 https://ollama.readthedocs.io/gpu/ 不在列表中的ollama无法调用GPU

命令行输入nvidia-smi

根据显示的CUDA Version安装对应的CUDA Toolkit Archive

https://developer.nvidia.com/cuda-toolkit-archive

如CUDA Version12.8则下载CUDA Toolkit 12.8.0 (January 2025)

评论